AI大模型用于智驾 出现幻觉怎么办?

最近,人工智能非常火爆,DeepSeek横空出世之后,席卷全球,汽车企业也不例外,纷纷宣布接入DeepSeek。在DeepSeek火爆之际,特斯拉的FSD将落地中国市场的消息也迅速传播开来。

特斯拉的FSD使用人工智能的大语音模型训练驾驶系统,在美国,FSD表现惊艳的新闻时常出现在网络上,当特斯拉的FSD落地之后,一批爱好者率先花费6.4万元升级智驾系统进行测试,表现并不尽如人意。有人认为,这是没有“喂”中国道路数据进行训练的结果。

前不久,记者参加DeepSeek讲座及培训,清华大学新闻学院、人工智能学院双聘教授沈阳提到,人工智能有幻觉,脱机状态下比例为22%,联网的状态下,幻觉比例也超过5%。汽车的智驾大量采用人工智能,在智驾的过程中出现幻觉怎么办?

两条智驾路线

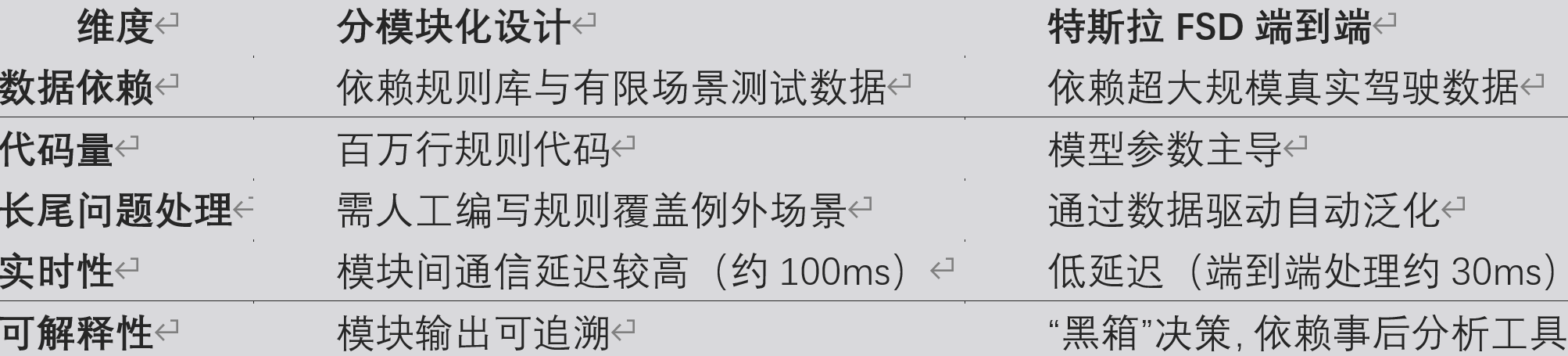

目前,智驾有两条技术路线,一是分模块设计,将驾驶任务分解为环境感知、自主导航、预测、决策、规控等多个独立阶段;二是端到端模式,系统直接接收车辆上摄像头等传感器收集的图像数据作为输入,经过神经网络处理后,直接输出控制车辆转向、制动、加速等操作的信号。

分模块设计是传统架构,智驾系统通过摄像头、雷达等传感器获取数据,通过算法, 生成环境模型,然后下达驾驶指令。基于规则引擎或有限状态机(FSM)判断驾驶意图。传统的分模块设计的技术特点是各模块独立开发,依赖人工规则和传统算法。

分模块设计的优点很明显,缺点也突出。由于各模块独立,可以进行验证,符合功能安全标准。追溯性比较强,如果发生故障或者问题,可定位至具体模块,可以单独优化不同模块的性能,比如,单独优化感知算法或规划策略。

分模块设计需要事先输入大量的场景,但是,世界上的道路千千万万,每一种场景都要输入,难度很大,事先采集场景的工作量也很大。有专家告诉记者,有些突发场景几乎不可能输入,比如,临时设置的路障,或者动物横穿马路等各种不可预测的行为。

分模块设计对各个独立模块的协同要求比较高,协同过程中容易出现“木桶效应”,比如感知延迟导致规划失效。分模块设计不仅要构建庞大的规则库,还需要大量的人员进行维护,据了解,Mobileye 旗下的EyeQ4仅负责维护的工程人员超2000人。

在端到端模式中,摄像头采集的数据直接通过神经网络进行处理,没有中间算法将传感器数据转换为某种中间形式。神经网络的输出即为最终动作指令,如转向、制动等,这些指令直接控制车辆的行驶。

端到端模式使得智驾系统的性能上限不再由规则代码决定,而是由数据和算力决定。输入的数据越多越优质,算力越强,模型性能越好。

端到端模式颠覆了传统的智驾模式,用数据驱动解决规则难以描述的复杂场景,这种模式不仅开发成本低,人工成本也较低。智驾系统可以通过自主学习掌握很多新的知识,这提高了智驾系统虎发效率,也节省了开发人员。有报道指出特斯拉的FSD只有300多位工程师,引起全球轰动的DeepSeek仅有140人,小小的团队创造了巨大的奇迹。

端到端模式包含大量的参数和复杂的神经网络结构,这使得验证其内部逻辑和决策过程变得非常困难。端到端模型在运行时产生的决策和输出往往难以直接解释或追踪其来源,这种不透明性使得验证人员难以确定模型是否做出了正确的决策,也无法准确判断模型在特定情况下的行为是否符合预期。

端到端模式非常依赖训练数据的质量,如果训练数据中存在偏差或不足,模型可能无法学习到正确的决策规则,从而导致验证失败。特斯拉落地中国之后,首批爱好者测试表现不佳,有人说主要原因是FSD通过使用互联网上公开可用的中国道路和交通标志视频,学习中国路况,这种图像产生的数据质量不太高。

资料来源:DeepSeek

智驾也会出现幻觉

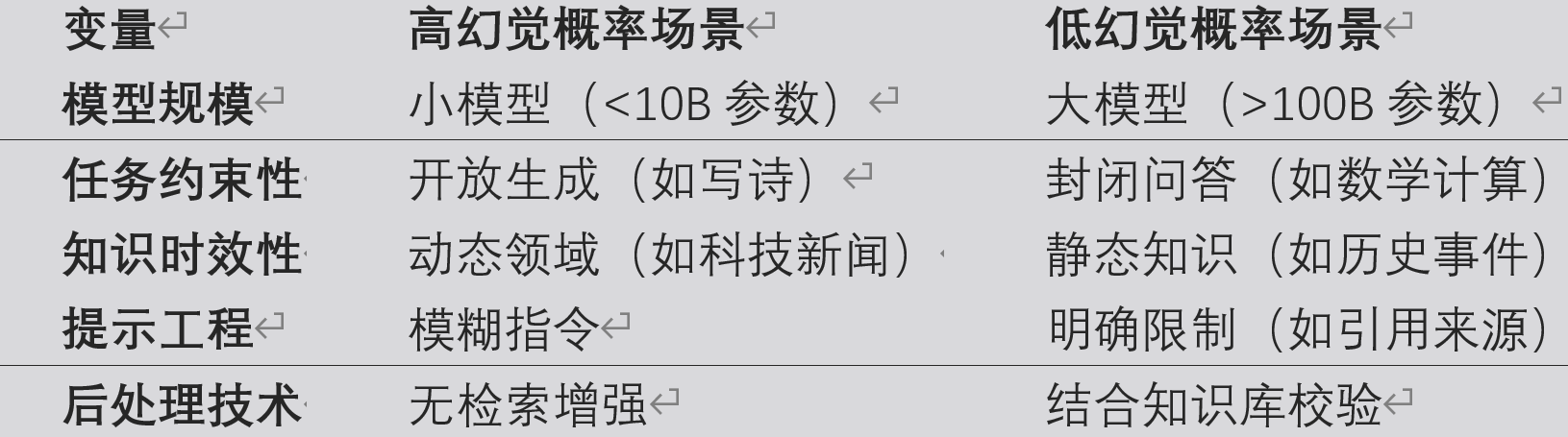

现在许多人使用AI帮助解决工作、生活中的问题,AI的回答,有时让人感觉迷茫。前不久,记者参加DeepSeek讲座培训,沈阳教授提到,人工智能有幻觉,DeepSeek在脱机状态下比例为22%,联网的状态下,幻觉比例也超过5%。

造假AI出现幻觉的原因是多方面因素综合的结果。AI模型从海量数据中学习,但数据本身可能包含错误、过时信息或偏见,这会导致AI把“有毒”数据纳入进来,最终影响输出结果。

生成式AI通过预测下一个词或像素的概率分布输出内容,而非理解真实世界因果,模型倾向于将局部模式推广到不适用场景,当上下文不明确时,模型可能选择“看似合理但错误”的路径。

记者采访人工智能专家了解到,AI用于计算的函数都会把最终结果收敛,得到一个在AI看来最优的输出结果,这个结果是AI认为的最优,并不一定与现实环境相一致。

目前,AI出现幻觉的概率不低,比如,在视频预测中出现幻觉的概率超过50%,即便在最简单的表格生成中,也会有3%~8%的差错率。

资料来潮:DeepSeek

目前没有良好的解决办法

Ai用于智驾系统出现幻觉,用什么办法解决这个问题,记者询问了多位人士,都没有给出肯定的答案,记者把这个问题抛给DeepSeek,DeepSeek从技术层面给出了自己的答案。DeepSeek认为,应对AI大模型在智驾中的幻觉问题,需结合数据增强、模型优化、多模态冗余、动态验证、人机协同五大核心策略,并通过严格的测试认证与法律框架确保安全。未来,随着因果推理、神经符号AI等技术的发展,模型的可解释性和可靠性将进一步提升,最终实现“幻觉可控”的自动驾驶系统。

DeepSeek认为,首先要进行数据优化与增强,采集涵盖极端天气、复杂路况的长尾数据,比如,施工区,动物闯入等不常见的数据需要补充进来供AI学习。在模型训练中引入对抗性样本,比如模糊图像、遮挡物等,从而提升模型鲁棒性。利用高保真仿真生成虚拟场景,弥补现实数据不足。

DeepSeek对模型改进也提出了建议,在模型中嵌入不确定性估计模块,比如贝叶斯神经网络,当置信度低时触发安全机制。DeepSee认为,智驾系统应采用Transformer等架构深度融合摄像头、雷达、激光雷达数据,交叉验证感知结果,通过轻量化模型,比如MobileNet、知识蒸馏等降低延迟,确保响应速度。

为了确保安全,DeepSeek建议实时对比多个传感器的独立推理结果,若差异过大则触发人工接管或保守策略,并且有必要设置物理规则约束,强制模型输出符合常识。为了确保安全,有必要做到硬件冗余,部署多套异构传感器,避免单点故障。DeepSeek建议建议摄像头+激光雷达组合在一起。

DeepSeek认为,在模型投入实际应用之前,应在虚拟环境中模拟百万级里程的极端案例,验证模型可靠性。要采用影子模式(Shadow Mode),在实车运行中并行运行新旧模型,对比决策差异,持续迭代优化。

目前,AI用于智驾,存在“暗箱”难题,DeepSeek认为,要强制模型提供关键决策的依据,便于事后分析,使得模型遵循ISO 26262(ASIL-D级)和ISO 21448(SOTIF)认证流程,从而确保安全。

DeepSeek认为,在目前阶段,人机协同至关重要,当系统检测到不确定性时,通过声光告警提示驾驶员接管,并预留充足反应时间。在无法安全决策时,系统应执行靠边停车、开启双闪等预设动作。

DeepSeek认为,误检率≤0.001%才能建立用户信任。目前,AI用于智驾,幻觉率较高,需要大家共同努力推进智驾技术发展。